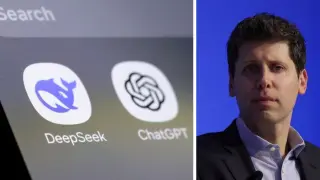

Sam Altman es posiblemente el empresario más influyente de la industria de la inteligencia artificial, con el permiso del CEO de Nvidia y todo el fanatismo y pasiones que levanta allá donde va con su chupa de cuero.

Se podría pensar que una persona como Altman, cofundador y director ejecutivo de la empresa que dio a luz a ChatGPT, no tiene miedo a nada en el terreno de la IA. De hecho, el empresario ha mostrado siempre una postura firme —y, en ocasiones, poco ética, según algunos colegas de profesión— sobre el desarrollo de una inteligencia artificial general (AGI, por sus siglas en inglés).

Sin embargo, en una entrevista reciente ha dejado claro que sí hay algo que, literalmente, le “aterra”.

El miedo de Sam Altman sobre la IA

El CEO de OpenAI ha expresado públicamente que no comprende cómo “todavía hay instituciones financieras que aceptan la huella de voz como autenticación para mover grandes cantidades de dinero o hacer cualquier otra cosa: simplemente dices una frase de seguridad y lo hacen”.

El motivo de su asombro, ha añadido, es que está seguro de que “la IA ha superado por completo la mayoría de los métodos de autenticación actuales, salvo las contraseñas”. “Es una locura que sigan haciendo eso”, ha sentenciado.

Altman ha subrayado el rápido avance que está teniendo la inteligencia artificial en este campo: “Ahora mismo, es una llamada de voz; pronto será un vídeo o una videollamada indistinguible de la realidad”.

“Estoy muy nervioso de que tengamos una crisis de fraude significativa e inminente”, ha concluido el CEO de la empresa, quien también ha aclarado que su compañía no está desarrollando este tipo de herramientas de suplantación.

El avance de la superinteligencia

Los ataques de este tipo están a la vuelta de la esquina, según Altman, y eso es precisamente lo que le quita el sueño: la idea de que actores maliciosos creen y utilicen indebidamente una ‘superinteligencia’ artificial antes de que el resto del mundo haya avanzado lo suficiente como para defenderse.

Altman también ha expresado su preocupación por la posibilidad de que los humanos pierdan el control de un sistema de IA superinteligente o de que le otorguen a la tecnología demasiado poder de decisión.

Varias empresas tecnológicas, incluida OpenAI, están trabajando para alcanzar la codiciada AGI. De hecho, el propio Altman dijo a principios de año que cree que la superinteligencia podría llegar este mismo 2025.